05-LM Studio

原创2025/11/2...大约 2 分钟

1. 安装库

lmstudio-python 已在 PyPI 上发布。你可以使用 pip 进行安装。

pip install lmstudio2. 快速示例:与 Llama 模型聊天

2.1 使用终端安装大模型

以下代码需要 qwen3-4b-2507 模型,如果没有该模型,请在终端运行以下命令进行下载。

lms get qwen/qwen3-4b-2507在此处阅读有关 LM Studio 的 CLI 中的 lms get 更多信息。

2.2 基础调用示例

import lmstudio as lms

model = lms.llm("qwen/qwen3-4b-2507")

result = model.respond("生命的意义是什么?")

print(result)3. 设置局域网服务器

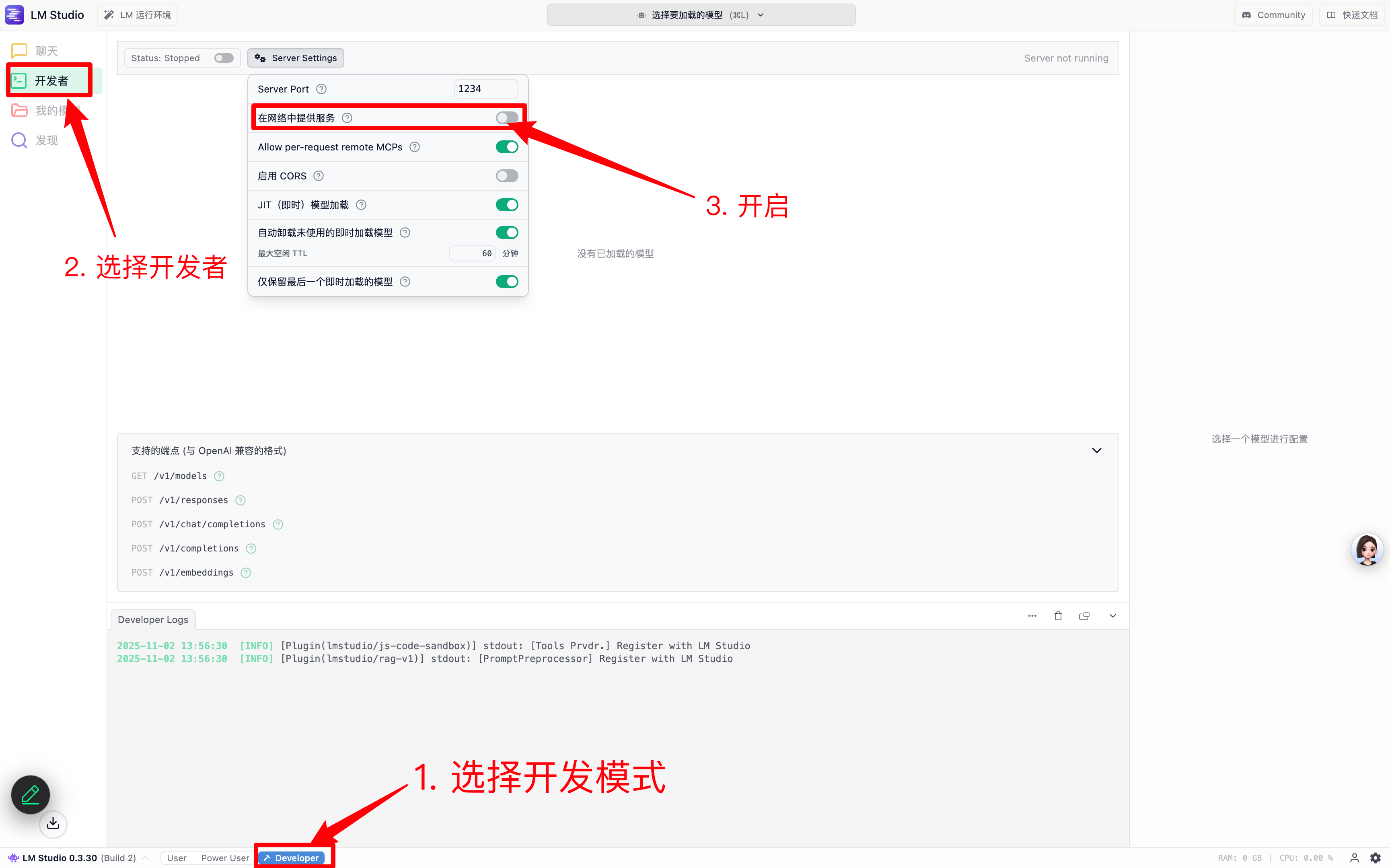

3.1 LM Studio 软件内设置

默认端口 1234,可以自行设置其它端口。

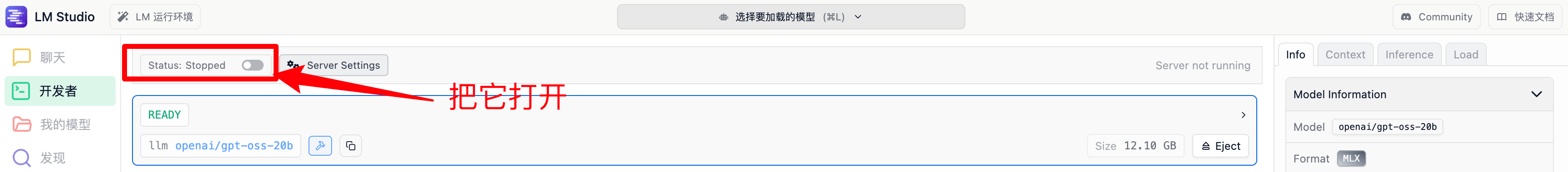

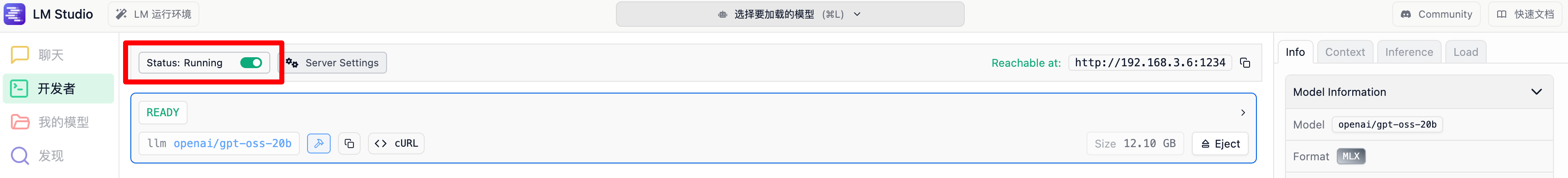

3.2 开启服务

3.3 程序中设置使用 http 模式

import lmstudio as lms

SERVER_API_HOST = "localhost:1234"

lms.configure_default_client(SERVER_API_HOST)3.4 检查指定的 API 服务器主机是否正在运行

很多时候,我们需要确保提供 API 的电脑是否正常启动,且可以正常使用,避免项目不能正常运行。

我们可以使用如下代码实现:

import lmstudio as lms

SERVER_API_HOST = "localhost:1234"

if lms.Client.is_valid_api_host(SERVER_API_HOST):

print(f"An LM Studio API server instance is available at {SERVER_API_HOST}")

else:

print("No LM Studio API server instance found at {SERVER_API_HOST}")3.5 局域网内 IP 地址获取

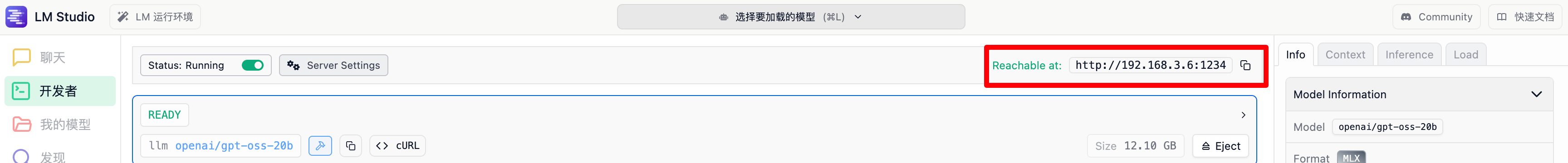

当开启 API 服务后,软件右上角会自行显示 IP 地址以及对应端口,看如下图:

3.6 最终设置

场景:Windows 设置为服务器,Mac 进行调用。下面的代码,写在 Mac 上面:

import lmstudio as lms

SERVER_API_HOST = "http://192.168.3.6:1234"

lms.configure_default_client(SERVER_API_HOST)4. 查看当前所安装的大模型

import lmstudio as lms

loaded_models = lms.list_loaded_models()

for idx, model in enumerate(loaded_models):

print(f"{idx:>3} {model}")